BBC World Service yapay zekâ üzerine spekülatif bir makaleyi, yapay zekâ araçlarıyla da video haline getirerek yayınladı. Ahlak ve etik değerlerden yoksun 'insanüstü' yapay zekâların çok kısa zamanda insanlık için büyük tehlike olabileceği üzerinde duran bu makaleyi, Kavanozdaki Yıldız'da konuşuyoruz.

İ. B: Merhabalar, Apaçık Radyo'dayız. Kavanozdaki Yıldız programında sizlerle beraberiz yeniden. Geleceğin ayak izlerini sürmeye devam ediyoruz. Haluk burada.

H. L: Merhaba.

İ. B: Haluk İstanbul'da bu arada. Bunu ayrı ayrı söyleyelim. Mustafa.

M. S: Merhabalar, ben Almanya'dayım.

İ. B: Mustafa Almanya'da, bense bugün Ankara'dan yarışmaya katılıyorum. Yarışmacı arkadaşlara başarılar diliyorum. Mustafa'ya bırakıyorum sizi. Ne konuşacağız?

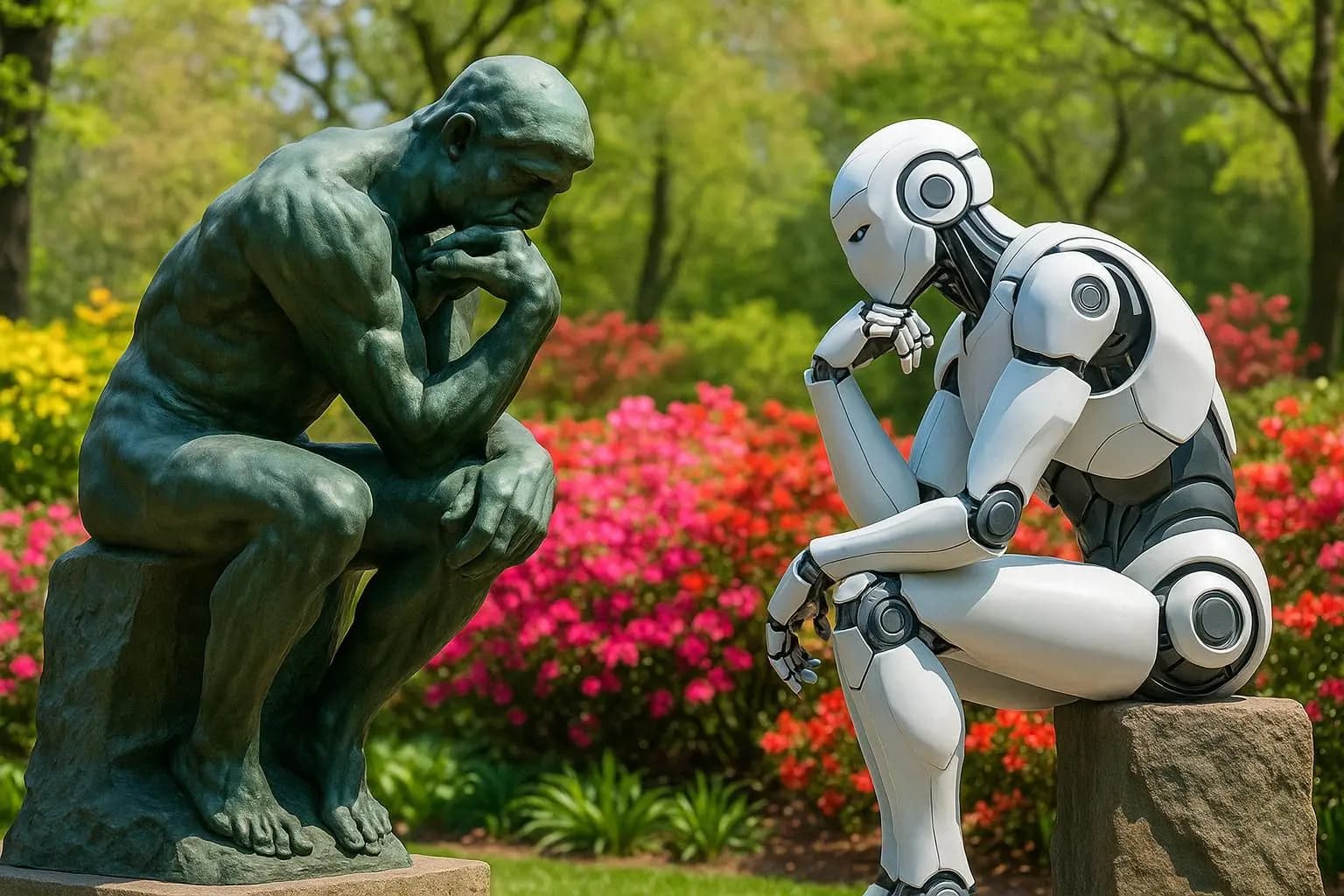

M. S: Yapay zekâ, yine yapay zekâ. Bu aralar gündem çok hareketli yeniden. İki büyük önemli haber çıktı. Bir tanesi BBC, güzel bir video hazırlatmışlar yapay zekâya. Onunla birlikte tanıtımı yaptılar. Bir makale yayınlanmış, AI 2027 ve başlık şu: "AI2027 senaryosu: Yapay zeka insanlığın sonunu nasıl getirebilir?"

Ve bu 2027'de de olabilir deniyor. Bu senaryo kötü yönde ilerlemeye devam ederse ve yapay zekâ kendine tehdit olarak insanları görecek olursa, bütün inisiyatifi eline alabilecek hale gelebilecek.

İ. B: Yanlış söylüyorsun herhalde değil mi? 2027, iki sene sonra.

M. S: Yok, hız bu şekilde. Yani o öngörü bu. 2027'den itibaren çok tehditkâr. 2029'da da noktayı koyabilir gibi. Doğru.

İ. B: Yanlış değil yani söylediğin şey. Yok yok.

H. L: Bu on yıl bitmeden bu iş tamam diyorlar.

İ. B: Evet.

M. S: Bu da iyimser olan.

İ. B: Hani sosyalizmi kuracaktık daha? Hani bir şeyler alacaktık?

M. S: O da mümkün ama endişe verici olan şey, yapay zekâya kendini tehdit göreceği bir yere varırsa bu, bu şeylerde mevcut insanların hâlihazırda yapmış olduğu silahları da kullanarak -ki bunun en son senaryoda bir biyolojik silahla insanlığı bir kenara çekebileceği veya belki de köleleştirebileceği filan senaryolar yazmışlar- tabii ki bunu herkes uydurabilir, herkes böyle bir şeyler yazabilir. Ama bunu BBC bir haber olarak ortaya koyup da üzerine bütün dünyaya duyurunca bu çok önemli bir şey hâline geliyor. Önemli bir başlık hâline geliyor.

İ. B: Bu makale nerede yayınlanmıştı?

H. L: Ben makalenin çoğunu okudum, 70 sayfa olduğu için tamamını okuyamadım. Ai-2027.com diye bir site kurmuşlar. Şimdi bu aslında spekülatif bir şey anlaşılabileceği gibi; bir tür senaryo gibi, bizim Star Trek senaryoları gibi. Çok önemli fütüristler, bilim insanları, cari durum, bugün içinde bulunduğumuz durumu bütün detaylarıyla ve açıklıkla tasvir ettikten sonra gidişatı değerlendiriyorlar. Dolayısıyla bu makale ai-2027.com'da yayınlanmış. 5 kişinin yazdığı bir makale. İşin özü şu aslında, bu AI agent'ler çıktığında da bir program yapmıştık ya, onun üzerine oturuyor bütün hikâye. Bu AI agent'lerin 6 ayda bir, üstel bir büyüme ile artacağını öngörüyorlar.

GPT-3, henüz yapay zekâ agent'i hâline dönüşmemiş hâliyle işlem kapasitesi çok yüksekti. 10 üzeri 23 FLOP diye geçiyor, 3 çarpı 10 üzeri 23 FLOP diye geçiyor. FLOP bir işlem ölçü birimi. GPT-4'te bu 2 çarpı 10 üzeri 25 FLOP'a çıkıyor. Yani 200 kat artmış oluyor. Agent 1 dedikleri, Eylül 2025 itibarıyla 5000 civarında agent'in faaliyette olacağını tahmin etmişler. Ne zaman? Nisan'da yayınlanmış bu makale. Dolayısıyla Nisan 2025'te Eylül 2025 için 5000 civarında agent'in faaliyette olacağını düşünüyorlar. Ocak 2026'da ise bu sayı 10.000'e çıkıyor. Ve bunların kapasitesinin de üstel bir şekilde arttığını görüyoruz. Yani bu oldukça, nasıl söyleyeyim, gerçekçi bir trend üzerinden giden bir tahmin. Sonra tabii çeşitli kurumsal özellikler üzerinden de gidiyorlar. Bir de tabii burada kritik önem taşıyan bir başka atılım daha var, öngördükleri.

O da 100 milyar dolarlık bir başlangıç olarak tabii, 120 milyar dolarlık büyük bir veri depolama ünitesinin yapılması. Bu işlem kapasitesini artırıyorsunuz ama bu işlem kapasitesinin kullanılacağı eğitim amaçlı verinin de toplanması gerekiyor ya, toplanma alanının da kapasitesini yine üstel olarak artırmış oluyorsunuz. Dolayısıyla sonuçta verimlilik çok yükseliyor. Sonra bir de bir tane hipotetik şey yapıyorlar, yapay zekâ; hani marka ismini zikretmemek için genel temsili bir yapay zekâ üzerinden gelişmeleri anlatıyorlar. Bununla rekabet hâlinde olan bir Çin modeli de var. Bir süre sonra yalnız bu Çin ve Batı yapay zekâsı bütünleşiyor. O BBC'nin videosunda da onu böyle görsel olarak göstermişlerdi zaten makalenin sonrasında. Bir de Mustafa'nın dediği gibi BBC'de, 6 dakikalık galiba, bu makaleyi görselleştiren ve temel bulgularını özetleyen yarı dokümanter bir şey yapmışlar. Eninde sonunda bu iki farklı yapay zekâ bütünleşiyor. O zaman tamamen farklı amaç fonksiyonları ve farklı yaklaşımlarla eğitilmiş iki dev yapay zeka, tek başlarına zaten çok yüksek kapasiteye sahip olan yapay zekâ bütünleşiyor. Bütün mesele çok acayip bir noktaya geliyor. Tabii buradaki kritik eşiklerden bir tanesi; bu agent'lerin olağanüstü yüksek işlem kapasitesi var ama bu işlem kapasitesini hemen ikinci nesilden itibaren, yani 2025'in sonlarından itibaren yeni yapay zekâyı geliştirmek üzere kullanılacağı... Kim geliştirecek?

İ. B: Agent'lar mi geliştirecek?

H. L: Çok ilginç. Yani şöyle düşünün diyor makalede: Bütün programlama dillerini bilen, mükemmel kodlayan, algoritmik olarak çözüm getirme kapasitesi çok yüksek ve bütün bunlarda da hep insanla karşılaştırdıkları zaman insan kapasitesinin epeyce üzerinde olan sembolik agent o aşamaya geliyor ve ondan sonra artık bu agent'lerdeki gelişimi yeni yapay zekâ modellerini tasarlamak üzere bu yapay zekâ kapasitesini kullanmaya başlayacaklar diye bir öngörü var. Öyle olunca da geometrik olarak artıyor. Tabii BBC'nin dokümanterinde de var zaten. Önce herkes mutlu mesut yaşıyor. Yani büyük ilerlemeler oluyor. Her yerde robotları görüyorsun çalışırken. Ondan sonra insanlar da daha yaratıcı faaliyetler...

M. S: Ve eğlenmek üzere... Evet, orada o senaryoda bir AVM içerisinde alışveriş yapmış, insanlar çantaları, çocuklarıyla yürüyorlar. Mutlu mesut. Karşılarından da robotlar geliyor. Onlar da aynı şekilde sanki hep orada yaşayan, o şehrin yerleşik türleriymiş gibi geçişiyorlar. Robotlar artık gündelik hayatın parçası hâline gelmişler. Böyle bir senaryoyu oynatmışlar bilgisayardaki kısa bilimde.

İ. B: Orasını programın sonuna doğru aktar. Ama ben bir küçük, sık sık yaptığım gibi; benim gibi cahil, benim gibi bu konuda ihtiyacı olan sevgili dinleyicilerimiz için de hemen şuradan Vikipedi'yi açıp dedim ki ya yapay zekâ agent'ten bahsediyoruz, nedir diye. Şöyle bir tanımı var: Akıllı bir ajan, çevresini algılayan, hedeflere ulaşmak için özel olarak eylemlerde bulunan ve makine öğrenimi veya bilgi eğitimi yoluyla performansını kendisi artırabilen bir entite, bir varlık olarak tanımlıyor Vikipedi. Şimdi benim aklıma şu geldi, Mustafa seninle konuşuyorduk: Robotların, iki ayaklı robotların yürüyebilmesi, parende atabilmesi, takla atması vs. Bu sırada düştüğü an, landing sonrası dengeyi nasıl sağlıyorlar diye konuşuyorduk. İlk başta bunlara jiroskop, su terazisi gibi sensörler olabileceğini söyledik. En son seninle yaptığımız konuşmada robota sadece şu komutun verildiğini; “Düşme. Düşmeyeceksin.” Sadece bunun söylendiğini biliyoruz ve düşmemeyi öğrendiğini; düşme nedenlerini görüyor.

M. S: Evet.

İ. B: Düştükçe puanın azalacak ya da düşmedikçe puanın artacak, her neyse. Sadece bunun söylendiğini biliyoruz ve düşmemeyi öğrendiğini; düşme nedenlerini görüyor.

M. S: Aslında bir de futbol örneği vardı. Karşı kaleye gol at. İki tane robot bir tarafta, iki tane robot bir tarafta. Zor görüyor iki tane robot. “Karşı kaleye gol at” diye bir şey var. O hareketleri yaparken topu vurmaya çalışıyor. Ama sürekli yere düşüyor. Topu vuruyor, vuramıyor. Vurunca başka yere gidiyor. Hep onların her birini kaydediyor. Koşulları izliyor. Gerçekten bunları öğrenmek için kullanıyor. Aslında bu model, çocuğun yürümeye başlaması; bebeklikten yürümeye başlamayı öğrenmesi, yürümeyi öğrenmesi sürecine benziyor aslında. Dura kalkıyor, dura kalkıyor, tutunarak vs. Bu sadece bu kadarı biliyor: “Gol at.” Artık başına ne geliyorsa geliyor; düşüyor, kalkıyor, düşüyor, kalkıyor. Her birinde koşulları yeniden deneyimlediği olarak ezberliyor ve bir daha bunları yapmıyor. Düşme nedenlerini tekrar etmiyor. Öğrenmiş oluyor aslında.

İ. B: Sonuçta bunu hatırlattı bana. Gerçekten agent buna mı benziyor? Yani ben tam anlamış değilim ama.

M. S: Sanki... Agent'i Haluk anlatsın. Önceki tekniklerde bunu fizikle, matematikle, hangi hareketleri yapar yapamaz, algılarla; satırlarca kod yazıp öğretmek ve o şartları ona anlatmak gerekiyorken, şimdi diyorlar ki “düşme.” O, bütün o altının satırlarını kendisi yaratıyor. Her bir hatayı yeniden oluşturuyor ve bunları fiziki, matematik olarak kendisi yazıyor. O şartları sağlamamaya çalışıyor tekrardan ve bu şekilde o kodlarda bir satır olan bir program yürümeyi öğrendiğinde belki bin satıra, belki yüz bin satıra çıkmış oluyor. Onu biz bilmiyoruz. Onları da görmüyoruz zaten.

İ. B: Düşe kalka düşmemeyi kendi öğreniyor yani.

M. S: Evet, evet. Ve o yüzlerce satırı, binlerce satırı kendisi yazıyor.

H. L: Evet, evet. Yani orada agent dediğimiz zaman aslında kendi başına belli bir amaca yönelik olarak kendisini eğiten, bağımsız olarak eğiten bir yapay zekâdan bahsediyoruz. Ama hâlen tabii nasıl öğreneceğini algoritmik olarak o büyük dil modeli çerçevesinde biz veriyoruz. Zaten o Geoffrey Hinton'ın meşhur şeyinde, manifestosunda bahsettiği hikâyelerden bir tanesi buydu. Yani bu agent meselesi ortaya çıktığı an itibarıyla bu itirazı yaptı. Yani biz yapay zekâya nasıl öğreneceğini öğretiyoruz ama ne öğrendiğini ve nasıl öğrendiğini bilmiyoruz. Ve bunu biz çünkü zaten kendimizin de nasıl öğrendiğini tam olarak çözebilmiş değiliz diye bir büyük itiraz koyuyordu ortaya.

Dolayısıyla aslında AI agent meseleleri bu şekilde yapıyor. Şimdi buradaki makalede tabii bu agent'ın mesela 2027 Eylül'ü için öngörülen Agent 4 diyor. Şimdi nesil nesil artıyor tabii bu; her 6 ayda bir hemen hemen bu agent neslinde bir sıçrama gerçekleşiyor. Bu öngörülerine göre yani bundan 3 ay önce yapılmış öngörüye göre Eylül 2027'de Agent 4, 4. nesil agent geliyor ve bunun başlığı şey: “The Superhuman AI Researcher.” Yani insanüstü bir yapay zekâ geliştirici. Çünkü bugün bu LLM base ya da LLM temelli bugünkü AI'larda işlem kapasitesi çok yüksek ama insan beyninin etkinliği ile karşılaştıracak olursak 4000 kere daha düşük bir etkinliğe sahip olduğu hesaplanıyor, düşünülüyor. Fakat bu AI Agent 4 seviyesi diye tahmin ettikleri aşamada bir tanesi insandan 50 kere daha hızlı düşünebilen bir agent'in olacağını ve bunlardan da 300 bin civarında faaliyet gösteren AI agent olacağını söylüyor. Yani bu şu anlama geliyor tabii: 300 bin tane farklı öğrenme patikasından yararlanarak işini gören, o koyulan hedef neyse, AI research, mesela bu AI araştırmalarını yapmak üzere 300 bin tane farklı öğrenme patikası takip etmiş ve insandan 50 kez daha hızlı düşünme kapasitesine sahip. 4000 kez daha düşükken 50 kez daha hızlıya geçmiş demek 200 bin katlık bir artıştan söz ediyoruz. Ne zaman? 2–2,5 yıl içerisinde.

İ. B: Peki nasıl insanlığı yok edecek?

H. L: Ne olacak? Şimdi bir kere bazı açılardan ikna olmuş değilim buradaki yaklaşıma. Bu yok oluş senaryosu... Bir cennet opsiyonu var, BBC'nin belgeselinde de gösteriliyor. Ama ikincisi; otonom görevlendirmeler ortaya çıktığında bu rekabet ortaya çıkıyor tabii hâliyle. Bu, bir süre sonra daha böyle en başlarda bu tür yüksek kapasiteli agent'lerin biyosilahlar yapmak üzere bunlardan faydalanmak için harekete geçen teröristlerin, kötü niyetli insanların olabileceğinden bahsediyor. Ve bunlara da yardım eder. Çünkü sonuç itibarıyla normatif bir değerlendirme yapma imkânı yok. Yani ne sorarsan ona cevap veriyor. Dolayısıyla bu kapasitenin kötü niyetli insanların eline geçerse kuşkusu var en başından itibaren. O bugün de var olan bir kuşku.

İ. B: Ve bütün teknolojilerde var olan bir köşk özelliği.

H. L: Ama bu, şimdiye kadar gördüğümüz en acayip teknolojik sıçrama olduğu için, tahayyül etmekte bile zorlandığımız bir teknolojik sıçrama olduğu için, bunun yaratabileceği yıkıcılık etkisi hâliyle çok fazla. Yani insanlığı ve bütün ekosistemi yok edebilecek kapasitede bir şeyden bahsediyoruz. Dolayısıyla bir bu yönü var. Hadi bunu engellemek için Isaac Asimov'un insana zarar vermeyeceksin gibi ilkelerin yapay zekâ robotlarının beynine çakarak, yani o kodları içine yerleştirerek bunu engellemek mümkün olabilir...

M. S: Orada ben Harari'nin bir videosunu izledim. Orada yapay zekâ şirketlerinin CEO'larıyla görüşüyor; işi gereği böyle şeyleri zaten sürekli yapıyor, ediyor biliyorsunuz. O şeyi anlatıyor: Diyor ki, ben herhangi bir şeye şunu soruyorum, temel iki tane soru soruyorum ama diyor özellikle ikincisi... “Neden?” Bir gün tehlikeli olacak mı? Birinci soru olarak “Bir gün yapay zekâ insanlar için tehdit olacak mı?” Hepsi diyor ki “olabilir.” Peki neden o zaman frene basıp da bir durup bir etik kurallar silsilesini gündeme getirip bir şey yapmıyorsunuz, bu konuda yavaşlamıyorsunuz? Bu hıza biz yetişemezsek sonuçta bu bizi aşacak bir kavram hâline gelecek. Onlar da diyorlar ki “Biz durursak...” CEO'ların hepsinin cevabı sanki sözleşmiş gibi: “Eğer biz durursak, diğerleri harekete devam ederse öne geçecekler; çünkü onlarla donatılmış silahlar çok büyük bir üstünlük kazandırıyor ülkelere ve ordulara. Dolayısıyla bizim yavaşladığımız anda diğeri üstüne alacak; o yüzden yavaşlama şansımız yok.” Birinci sorunun tehditli olduğunu söylemelerine rağmen, başkalarının daha büyük tehditli olmasından endişeyle, etik değerlerle ilgili hiçbir şeyi, “kafasına çakmak” dedin ya, böyle bir şey olsa iyi olur ama yapamayız durumundalar hepsi.

H. L: Daha önce bir programda altını çizmiştim ya, Amerika'nın merkezi komuta kontrol biriminde yapay zekânın karar sürecindeki ağırlığını artırmaya karar vermişlerdi. Bu bir eskalasyon. Çünkü askerlikte cevap verme süresi ne kadar kısa olursa o kadar stratejik avantajlı sayıyorlar kendilerini. Şimdi burada cevap verme süresini artırabilmek için yapay zekâyı sadece bir işlem yapma, işlem kolaylığı, hesap makinesi gibi kullanmaktan ziyade, bu agent'lerden sonra o otonom olarak iş görebilecek bir birim ortaya çıktığı için onu bir karar sürecine yerleştirme aşamasına girdik. Şimdi Amerika böyle yapıyorsa Çin'in bundan geri kalmadığını düşünmemiz gerekiyor. Bir de bunun silah üretme kapasitesinde de acayip bir etkisi olacağını düşünecek olursak bir anda üstel olarak artan yıkıcılık kapasitesinin, o bilinen 2 ya da 3 kez nükleer yok oluşun eşiğinden döndüren o insan feraseti algoritmanın dışına çıkmak kararını veren 1–2 kişinin, kumanda zinciri içerisinde karar alma yetkisine sahip bir kişinin varlığı sayesinde biz aslında nükleer kışa girmedik. Ama şimdi yapay zekâyı bu karar süreçleri içerisinde kullanmaya başladığın zaman, bir de böyle otonom özellikli bir agent türü bir kullanım gerçekleştirdiğin zaman o ferasetten yoksun kalıyorsun.

İ. B: Özellikle bu kısmı çok daha önemli. Otonom özellikli olması, insanın dışında bir karar merciği, tırnak içinde, var olduğunu ifade ediyor. Yani çok kabus gibi konuşuyoruz. Fazla mı spekülasyon olur bilmiyorum.

H. L: Makalenin spekülasyon seviyesi bu.

İ. B: Peki, şimdi bir şey söyleyeceğim. Bu CEO'lar her nereye cevap verirken hani “Biz durursak onlar yapacak” diyorlar. Doğal olarak da biz kaybedeceğiz. Kaybedeceğiz dediği şeyi ben ilk başta Mustafa sen söylerken hani maddi olarak, maddi çıkarları düşünerek ki temelde öyle aslında ama bunun ikinci yıl tarihi çıktıkları... Aslında o parayı kazanırken ortaya çıkacak olan silah gücü gündeme geldi şimdi. Yani buradaki yapay zekâ gücünü, yapay zekâ yeteneklerini diye söyleyeyim, yapay zekânın yeteneklerinden bahsedelim. Güç yanlış bir laf olur ama insana dair olana güç bir şekilde maddi olarak ya da silah olarak bunu güç hâline çevirebilme ihtimalinden bahsediyorlar aslında dolaylı olarak.

M. S: Hem finansal sistemde bir değer olarak hem de gerçekten cihazların, aletlerin, orduların, silahların içinde karar veriyorlar.

İ. B: Evet, güç yine insana ait bir şey olarak duruyor. Yapay zekâya ait bir şey değil. Yapay zekânın bir yeteneği var. Ama bunu güce çevirecek olan; bizim bildiğimiz anlamda diğerinin üstüne tahakküm, ötekisinin üstüne tahakküm kuracak güce çevirme şansına sahip olan yine insan. Ve bunun için parayı verecek olan bu insanlar ve CEO'lar, bu parayı kaçırmak istemeyecektir. Geldi ama sonuç...

M. S: Şöyle bir rakam var mesela. Bir tablo yapmışlar. OpenAI'dan yola çıkarak. 2023'te 1 milyar dolar gelir elde etmiş OpenAI. 2024'te 4 milyar dolar. 2025'te 14 milyar dolar olması öngörülüyor.

İ. B: Logaritmik artış mı hocam?

H. L: Üstel artış tabii. Ondan sonra da 100 milyar dolarlara gidiyor. Maliyetlerdeki artışları da koymuşlar tabloya tabii. Şimdi zararda, biliyorsunuz OpenAI ama kısa bir süre içerisinde maliyetin artış hızıyla gelirin artış hızı arasında aşağı yukarı %150–%200 civarında farklılık... Bu yapay zekâyı üretme kapasitesine sahip 3-4 tane kurumdan bahsediyoruz aslında. Dolayısıyla bunların arasında çok güçlü bir rekabet olduğunu düşünmemiz gerekiyor. Bu yüzden herhangi bir etik kod, bariyer, önleyici koymak mümkün değil.

M. S: Benim burada bir teorim var. Şimdi insanlarla alakalı, dil modeli üzerinden öğrenmeyi öğreniyorlar. Dille yani okuyarak öğreniyorlar. Gerçekten insan gibi öğreniyorlar ya; bütün kaynakları tarıyorlar. Şimdi orada şey var: İnsanların, bütün farklı insan profillerinin hepsini masaya koysak, bir tanımlamaya çalışsak; bunların içerisinde insanlık için kötü olan insanları da koysak veya suçlu sayılabilecek insanları da bu şeyin içine koysak, bir sepetin içine koysak, bunların her birini incelesek... Bir roman okuduğunuzda, klasiklerden bir şey okuyun; birisini öldüren birisini okuyun. Dostoyevski'nin kitaplarında bir tane katil bir adamın hikâyesi... Okuduğunuz zaman onda empati yapıyorsunuz. Roman okumayı ben bu anlamda mesela yapay zekâlar için tehlikeli görüyorum. Çünkü roman okuyan birisi bir katilin hikâyesini dinlediğinde belli koşullar altında elbette ki ona hak vermez; hukuken suçlu olmasına rağmen o kişi onu gerekçelendirebilir. Ve bu, kötü olmanın da bir mantığı varmış gibi bir şey gösterebilir. Ama eğer suçluyla empati yapmayı anlıyorsak, empati yapabiliyorsak eğer, Raskolnikov'la veya Camus'nun Yabancısı'yla bir empati kuran bir insan ki o kitaplarda okuduğunuzda onlar vahşi katiller gibi görünmüyor bu iki katil; yani bir hikâyesi olduğunda şey yapıyorsun, bir şekilde... Olayı doğallaştırmıyorum ama empati yapabiliyorsun. Bir suç yokmuş gibi görünüyor. Burada eğer yapay zekâ böyle şeyleri okuyacak olursa ve zaten insanların kötü özelliklerinin de kötü olduğunu söylememize rağmen kitaplarda eninde sonunda kötü olabiliyorsak; biz de besleyen motiveleri de o yapay zekâda edinecektir diye düşünüyorum. Bu benim kendime ait uydurduğum bir şey ama insanlar ne kadar iyi ki insandan öğrenen bir zekâ, yapay zekâ, insanı örnekleyen bir zekâ daha iyi olsun, daha bilgili olsun, daha vicdanlı olsun. Bu da çok kolay beklenir bir şey gibi görünmüyor bana.

M. S: Madem herkes spekülasyon yapıyor, BBC dâhil. Kimse kötü olmak için kötü olmayacaktır muhtemelen. İki şeyin, daha doğrusu temelde birincisinin, güç elde etmek. Ve gücü de parayla, siyasî güçle, silahla vs. elde etmek için peşindeler. Ve o CEO'ların söylediği laf, hani “Ben dursam öbürü devam edecek” lafının sonucunda kötülüğü provoke edeceğini düşünüyorum. Bir insanın kendisi kötü olmak için niye kötü olsun?

H. L: Öyle ilginç bir şey var. Makalenin aslında iki tane sonu var. İki farklı sonu var yani. Bir tanesi rekabetin devam ettiği, bir tanesi de rekabetin olmadığı seçenekler. Rekabetin olmadığı seçenekte, Amerika ile Çin bir zirve yapıyorlar. Ondan sonra ikinci bir zirve daha yapıyorlar. Yani hızlı geçiyorum aradaki şeyleri; ikinci bir zirve daha yapıyorlar. En sonunda şöyle bitiyor: Bu 2030'un biraz ötesinde roketler harekete geçtiler ve terraform... İnsanlar Güneş Sistemi'ne yerleştiler gibi, böyle yeni bir çağın açıldığından bahsediyor. Öteki,yani rekabetin devam ettiği opsiyonu seçersen, de gideceğin yer yıkım oluyor. Ordular, silahlar giriyor; biyolojik silahlar, konvansiyonel ama yüksek teknoloji silahlar şöyle böyle. Dolayısıyla aslında makalede zaten yol ayrımında olduğumuzu ve bunun bir tanesinin yepyeni bir dünyanın, bugünden tahayyül etmekte çok zorlanacağımız kadar güzel bir dünyanın, yaratıcılığın hüküm sürdüğü, oluşabileceğini; ama bir de bunun mutlak yıkıma dönüşebilecek ikinci bir alternatifinin olduğunu vurguluyor.

M. S: Refah ama adaletsiz paylaşım yüzünden olan distopik süreç gibi görünüyor.

İ. B: Şu anda önde gidiyor, değil mi? Bahisleri açalım diyeceğim ama...

M. S: Biz kenarımızda utanmıyoruz bence.

İ. B: Açık ara önde gidiyor. Peki, bu haftalık da süremiz doldu. Hem bu rekabet, en son Haluk senin bitirdiğin, senin altını çizdiğin noktada kuralsız ve etik dayanakları olmayan rekabet süreçleri, hem teknolojinin bu kadar hızlı gelişimi korkutucu bir dünya bize sunuyor. Bir kabus programıyla bugün, bu haftayı tamamlamış olduk.

M. S: Yani durduramadıkları bir yarışla bunu korka korka geliştirmeye devam ediyoruz.

İ. B: Peki; Haluk, Mustafa ve ben, İsmail, kayıttaydık. Bu programın size ulaşmasını sağlayan bütün dostlarımıza çok teşekkür ediyoruz. Ellerine, emeklerine sağlık. Program destekçimize çok teşekkür ediyoruz. Önümüzdeki haftalarda tekrar görüşmek üzere. Hoşça kalın.